Suis-je maître de mon cheminement vers l’information? En tant que professeurs-documentalistes soucieux de former nos élèves à la notion de fiabilité, les Sciences de l’Information nous ont apporté des méthodologies afin d’établir la qualité et la véracité d’une information. Ces méthodologies nous ont permis de traiter avec eux les modalités de la recherche documentaire, à évaluer les sites canulars, les infox et autres éléments informationnels qui circulent, à reconnaître l’autorité d’un site par rapport à ceux qui seraient moins sérieux, à observer les algorithmes de recherche et les résultats de nos requêtes. Le contexte actuel nous interroge, car il concerne la citoyenneté mais aussi le bien-être de nos élèves, chacun pouvant aisément adhérer à des discours pseudo-scientifiques ou se croire neutre et objectif. De ce fait, des fabriques d’ignorance se couplent à des illusions de connaissance, impliquant un besoin de clarté dans l’information ambiante. L’esprit critique et l’éducation aux médias peuvent s’enrichir de la recherche en sciences cognitives, en didactique des sciences, afin d’offrir des outils d’autodéfense intellectuelle. Il faut toutefois rester vigilant au fait que la salle de classe est un environnement qui offre davantage de paramètres et variables (notamment sociales) qu’une expérience contrôlée.

Suis-je maître de mon cheminement vers l’information? En tant que professeurs-documentalistes soucieux de former nos élèves à la notion de fiabilité, les Sciences de l’Information nous ont apporté des méthodologies afin d’établir la qualité et la véracité d’une information. Ces méthodologies nous ont permis de traiter avec eux les modalités de la recherche documentaire, à évaluer les sites canulars, les infox et autres éléments informationnels qui circulent, à reconnaître l’autorité d’un site par rapport à ceux qui seraient moins sérieux, à observer les algorithmes de recherche et les résultats de nos requêtes. Le contexte actuel nous interroge, car il concerne la citoyenneté mais aussi le bien-être de nos élèves, chacun pouvant aisément adhérer à des discours pseudo-scientifiques ou se croire neutre et objectif. De ce fait, des fabriques d’ignorance se couplent à des illusions de connaissance, impliquant un besoin de clarté dans l’information ambiante. L’esprit critique et l’éducation aux médias peuvent s’enrichir de la recherche en sciences cognitives, en didactique des sciences, afin d’offrir des outils d’autodéfense intellectuelle. Il faut toutefois rester vigilant au fait que la salle de classe est un environnement qui offre davantage de paramètres et variables (notamment sociales) qu’une expérience contrôlée.

Pourquoi repenser son rapport à l’information ?

1. Faire preuve d’humilité cognitive

Education et discours pseudo-scientifiques :

- Plusieurs études, par le passé, ont montré que les enseignants avaient un niveau de croyance au paranormal et aux pseudosciences supérieur à la moyenne française (H. Broch. 1999. / D. Boy. 2002 ).

- Les neuromythes en éducation ont la vie dure. Les profils d’apprentissage , la théorie des intelligences multiples, les notions de cerveau gauche-cerveau droit, le cerveau reptilien, l’opposition émotion / rationalité, les pyramides de Dale ou de Maslow… n’ont pas d’assise scientifique aujourd’hui, mais sont intégrés dans la pédagogie de nombre d’entre nous.

Ces distorsions peuvent être :

- de type sensoriel : les illusions d’optique (persistances rétiniennes, déformations, etc) montrent comment le cerveau peut interpréter les données des sens. Cela peut occulter des informations. C’est le cas, par exemple, du point aveugle (partie de la rétine reliée au nerf optique).

- de type mnésique : notre cerveau n’est pas un disque dur. A chaque évocation de souvenirs, il recrée l’événement et peut le déformer légèrement. La psychologue Elizabeth Loftus travaille sur ces questions. Ses expériences ont montré qu’il était possible de suggérer à des enfants qu’ils avaient « enlacé Bugs Bunny lors de leur séjour à DisneyLand » ou que dans le visionnage d’une séquence vidéo, « il y avait une grange » (pourtant absente). Ses témoignages dans des procès ont fait inculper des thérapeutes, qui avaient fait émerger des faux-souvenirs (en fait, « suggérés ») chez leurs patients pour expliquer un mal-être (thérapies de la mémoire retrouvée). Ces travaux mettent à mal la technique judiciaire du Line Up (Etats-Unis), où une victime doit reconnaître un agresseur parmi un panel de personnes. Dans de nombreux cas, il apparaissait que la victime pouvait reconfigurer son souvenir en se fixant sur un visage et faire commettre une erreur judiciaire. Dans cette logique, un témoignage n’est pas vu comme preuve suffisante dans certains disciplines scientifiques (sciences médicales par ex.).

de type attentionnel : un trop plein d’informations peut provoquer une cécité attentionnelle. Le cerveau ne peut pas observer tous les éléments qu’il a à traiter. La célèbre expérience de Simmons a montré que dans une vidéo, en se concentrant sur le nombre de passes, certains ne voyaient pas le gorille à l’écran. Le test de Stroop montre également la difficulté du cerveau à inhiber certains éléments informationnels pour se concentrer sur d’autres. Dans la publicité Colgate ci-contre, combien d’entre nous se focalisent sur la dentition de la personne sans voir un détail plus surprenant ?!

de type attentionnel : un trop plein d’informations peut provoquer une cécité attentionnelle. Le cerveau ne peut pas observer tous les éléments qu’il a à traiter. La célèbre expérience de Simmons a montré que dans une vidéo, en se concentrant sur le nombre de passes, certains ne voyaient pas le gorille à l’écran. Le test de Stroop montre également la difficulté du cerveau à inhiber certains éléments informationnels pour se concentrer sur d’autres. Dans la publicité Colgate ci-contre, combien d’entre nous se focalisent sur la dentition de la personne sans voir un détail plus surprenant ?!

- elles peuvent être liées à nos facultés de jugement et de raisonnement. Erreurs de logique, confusion entre corrélation et causalité, mésestimation de son niveau de connaissance, paréidolies…peuvent se glisser dans notre rapport à l’information et à sa validation. On parle beaucoup de biais cognitifs actuellement : nous allons voir qu’ils sont souvent pris comme des défauts. Surtout, ils sont souvent surestimés au mépris de causes externes (mésinformation ambiante, contexte socio-économique, représentations culturelles..).

2. Biais et dissonance cognitive

Certaines distorsions sont nommées biais cognitifs : on les évoque lorsque l’une de nos heuristiques génère une déviation par rapport à une réponse ou décision qui serait plus adéquate. Dans la plupart des cas, il s’agirait de mécanismes qui ont permis des avantages dans l’évolution de l’homme dans son environnement, en réagissant vite. Ils ne sont pas négatifs en soi, tout dépend du contexte. D’ailleurs nos erreurs ne sont pas toujours le fruit de ces biais mais peuvent être le fruit de causes externes (informations contradictoires dans les médias, adhésion à l’avis d’un groupe, etc). Dans certaines situations modernes (raisonnement scientifique, débat, prise de décision, validité de l’information), ces raccourcis cognitifs nécessitent de se décentrer, et justifient le collectif dans la production de connaissance.

Quelques biais :

- Biais de confirmation : tendance à ne considérer que les sources d’information qui sont déjà en lien avec nos croyances (ce qui n’est pas une mauvaise chose en soi, notamment pour convaincre dans une situation argumentative, tout dépent du contexte et du risque de s’enfermer dans une bulle de croyances.

- Effet Dunning-Kruger : tendance à surestimer nos connaissances dans un domaine, lorsqu’on ne voit pas la marge de connaissances à acquérir pour en avoir une bonne maîtrise (légèrement contesté aujourd’hui car dépendrait de contextes culturels.)

- Effet Barnum : accepter une vague description de sa personnalité comme s’appliquant spécifiquement à soi-même (ex : un horoscope, le discours d’un medium).

- Illusion des séries : percevoir à tort des coïncidences dans des données dues au hasard (exemple : jouer le 18 à la roulette parce qu’il est déjà tombé deux fois / dans une guerre, croire à la présence d’espions dans un quartier, à la suite de frappes militaires qui ne touchent pas ce quartier, alors que les frappes sont tirées au hasard).

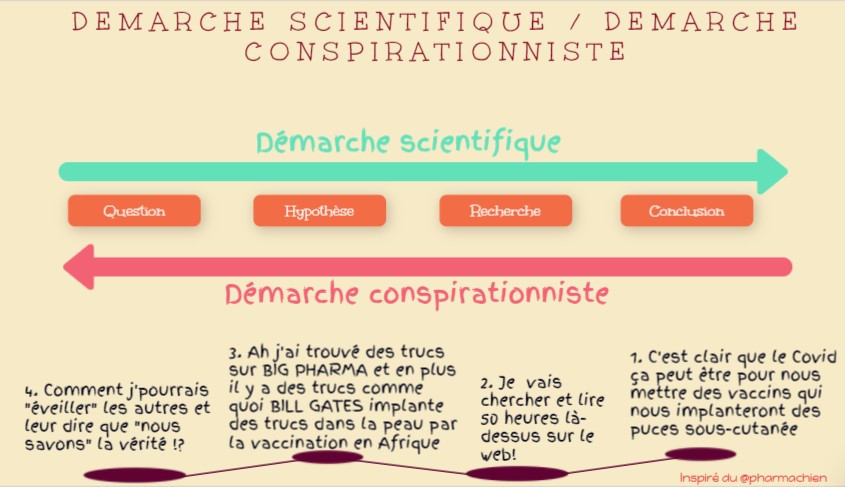

Dans notre recherche d’information, ces biais favorisent souvent la dissonance cognitive. Il s’agit de la tension que nous éprouvons face à une information qui réfute notre système de croyances, qui peut nous faire inventer des justifications pour résoudre cette tension. Exemple « fumer est dangereux? Oui mais cela m’aide à ne pas grossir« . Le psychologue Leon Festinger est à l’origine des travaux sur ces questions. La dissonance cognitive permet de comprendre la logique conspirationniste. Toute preuve de supercherie renforcera celui qui croit en une théorie complotiste sans preuve, car il l’intégrera à son système de convictions. (« la source que tu me montres doit être celle de quelqu’un qui est payé par le gouvernement », « tu es un mouton, je suis éveillé », etc).

Les biais n’expliquent pas tout pour autant! Il y a des éléments sociaux, culturels, éthiques, qui peuvent expliquer nos adhésions, croyances ou opinions. Ils peuvent être utiles pour avoir conscience de notre rapport à l’information et à notre raisonnement mais ne constituent pas l’essentiel : la désinformation s’explique aussi par tout un contexte.

De plus, de nombreuses ressources sur les biais les présentent comme des défauts, et font référence à la théorie Système1/Système2 de Kahnemann et Tversky : ces biais sont obtenus dans des conditions expérimentales bien précises (énoncé prototypé, consigne précise, réponse optimale attendue) alors que la réalité est beaucoup plus complexe. D’autres recherches (Gigerenzer, Mercier, Sperber) alertent notamment sur le risque de trop les déconstruire ou d’opposer intuitions et raisons ! (dans de nombreux cas une intuition rapide est plus efficace qu’un raisonnement).

3. Critères épistémologiques pour gagner en validité

Certains discours sont souvent à rebours d’une démarche qui partirait des faits, ils auront tendance à « piocher » ce qui corrobore une théorie préexistante.

- Parmi les principes qui peuvent amener une réflexion sur la nature d’une connaissance scientifique, on retiendra notamment :

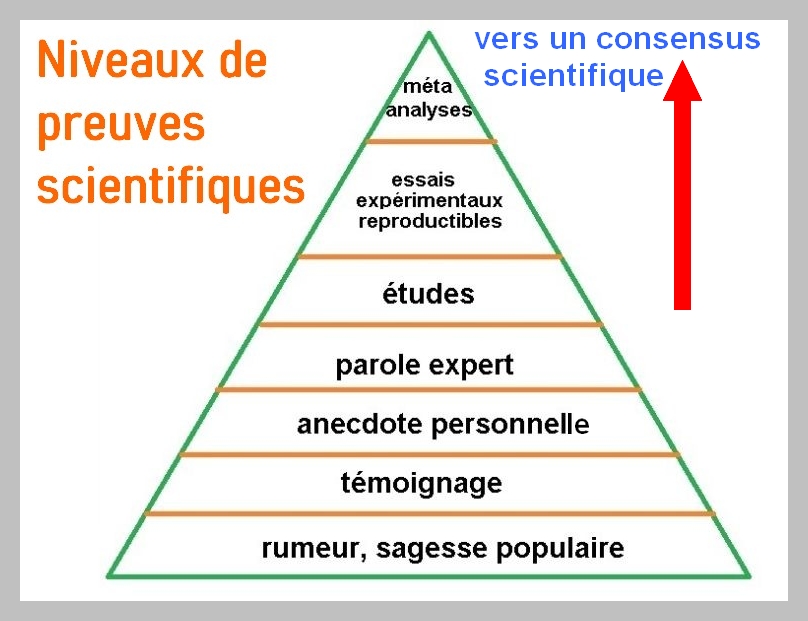

- Toutes les preuves en science ne se valent pas

Maîtriser la valeur d’une information scientifique revient à connaître plusieurs types. En haut de cette pyramide, utilisée dans les sciences bio-médicales, on trouvera les méta-analyses (qui combinent les résultats de plusieurs études indépendantes sur un sujet avec un protocole d’expérimentation reproductible). On dit souvent qu’un témoignage comme preuve, ne suffit pas, dans certains contextes expérimentaux (MAIS il reste essentiel dans des contextes judiciaires ou en Sciences Sociales, en Histoire..). Cette pyramide apporte une aide mais ne constitue pas un schéma figé ! D’ailleurs dans la réalité, il n’y a pas UNE méthode scientifique , réglée comme une suite d’étapes figées!

4. Argumentaires fallacieux

Le débat argumentatif permet de confronter l’avis d’un élève à ses pairs, il montre qu’une question socio-scientifique est parfois complexe (et ne se résume pas à une position Vrai/faux). On peut aussi relever les arguments (dans les médias, dans la publicité, dans les discours) qui ne constituent pas de preuves en soi. On trouve des exemples d’activités de professeurs-documentalistes en ligne sur ce sujet. A noter qu’un argument n’est pas toujours fallacieux en soi, cela peut dépendre du contexte ou de l’argumentaire général (l‘appel à l’autorité est plutôt une bonne chose lorsque je m’appuie sur des personnes qui s’y connaissent mieux que moi sur certains sujets). Un argumentaire ne se résume pas à de la logique de base : il y a un contexte, des éléments rhétoriques, il faut comprendre la thèse principale, etc.

Certains aspects d’argumentation fallacieuse restent récurrents dans les théories du complot en ligne. Le raisonnement panglossien, la généralisation abusive, l’effet Fort ou mille feuilles-argumentatif : dans ce dernier, on empile des arguments parfois faibles, de manière rapide, si bien que cet empilement donne une sensation de véracité en saturant notre capacité de raisonnement. On oubliera pas que l’adhésion au complotisme n’est pas que cela. Elle peut faire partie d’une construction sociale ou d’une colère justifiée face à une situation qui pose problème.

5. Pseudosciences et conduites sectaires

Le déconfinement de mai 2020 a été suivi d’une lettre du ministère sur les dérives sectaires. Il s’agit notamment de :

- « sensibiliser les élèves aux risques des discours dangereux qui prodiguent de faux

remèdes et des conseils dangereux en lien avec le COVID-19 » – certains youtubeurs se prétendant lanceurs d’alerte ou médecins « libres » diffusent des conseils de santé dont on peut aisément avec des élèves, et d’après des recherches, conclure qu’ils reposent sur des informations mensongères. Ceci est d’autant plus faisable si l’on a travaillé certains raccourcis cognitifs que l’on retrouve dans leurs discours (effet Barnum, ancrage, biais statistiques, détection d’agent) et certains argumentaires fallacieux (ponctués d’appels à la tradition, appels à la nature, fausses-corrélations, etc). On peut aussi travailler les raisons de l’adhésion à ces croyances (perte de confiance, manque de clarté, contextes économiques, etc). A noter que celà peut être contreproductif : faut il faire « connaître » ces youtubeurs qu’ils ne connaissaient pas? - « développer l’esprit critique des élèves pour mieux lutter contre la désinformation, les

fake news, les rumeurs et les théories complotistes« . Le professeur-documentaliste peut, sans lui prodiguer ce qui est vrai, ce qui est faux (éviter une posture d’expert prescripteur), développer chez l’élève ces outils critiques. Dans certains cas, il est possible de mettre en place des protocoles simples d’expérimentation (voir les ressources du Cortecs.) ou de réfléchir à nos raccourcis que berçent ces discours.

6. Esprit critique et recherche web

La question des bulles de filtres: elles désignent le filtrage de l’information qui nous parvient et peut nous placer dans une bulle culturelle et intellectuelle. Ce filtrage peut être opéré :

- indépendamment de ma personnalité : les résultats d’une recherche, sur un sujet scientifiquement controversé, peuvent privilégier des liens non scientifiques ou des filtrages techniques. Par exemple : inscrire dans Google « bougies hopi » (une bougie censée nettoyer l’oreille) ne me donnera aucun lien qui indique que ce produit en ligne ne repose sur rien de scientifique / n’est pas du tout un type de bougie utilisé par les indiens hopi…

- être le fruit d’une personnalisation : la recherche peut alimenter mon biais de confirmation en ne me donnant que les informations qui correspondent à ce que j’attends (par exemple: sélectionner dans Google Actu, les médias qui sont en lien avec mes penchants politiques et éviter toute contradiction). Un confor (ce qui ne heurte pas mes croyances – ne crée pas de dissonance cognitive) peut être ressenti grâce à ces « chambres d’écho ». A noter que vouloir se confronter à des ressources contradictoires à mes opinions peut être un leurre : on ne va se focaliser que sur les erreurs de ces discours. Notons également que cette tendance à la confirmation n’est pas que négative. Dans bien des contextes, elle nous aide à nous protéger dans un environnement numérique « safe », ou à chercher des arguments et sources pour appuyer notre thèse.

La notion de bulle de filtrage reste controversée selon les chercheurs. Pour certains, elle peut manifester une volonté de protection de l’usager contre des contenus inappropriés. Certains notent également qu’on peut facilement tomber sur des informations contradictoires quand on fréquente les réseaux.

L’essor de la captologie : un modèle économique entre neurosciences et sciences informatiques, qui s’intéresse à la captation de l’attention en ligne. Si l’objectif des GAFAM était auparavant de nous faire gagner du temps (service for data), aujourd’hui les stimulis regorgent d’inventivité pour nous faire passer notre temps en ligne (service for time). Exemples ? Le scrolling addictif de Twitter ou Facebook, ou la technique des {…} quand quelqu’un nous y écrit en privé. L’attention étant une denrée limitée, Albert Moukheiber, docteur en neurosciences, pense qu’il faut étudier “comment au lieu d’utiliser ces connaissances en neurosciences sur les limites de l’attention pour persuader les gens, on pourrait faire du design de l’information pour aider la personne à parvenir au résultat qu’elle cherche. » (Captologie, webinaire de la chaîne de zététique « la tronche en biais« ). Les capacités (réelles ou supposées?) à absorber notre attention et à piéger l’internaute ne font toutefois pas consensus.

Des biais de raisonnement inhérents à nos requêtes ? L’usage des mots clés, la sélection des résultats peuvent-être liés à des idées que nous nous faisons déjà avant même de vérifier. Effectuer une recherche sur le coronavirus en inscrivant « covid19 complot » dans sa barre de recherche, orientera forcément la recherche vers certaines théories nauséabondes.

Eric Boutin, chercheur en sciences de l’information, indiquait (dans biais cognitifs et recherche d’information sur internet) que l’internaute « privilégie les premières réponses envoyées par l’outil de recherche en faisant l’hypothèse qu’elles seront représentatives de l’ensemble » . Souvent, lors de sa recherche, « il considère comme confirmatoire une information redondante. » Cette « loi des petits nombres » correspond à l’idée selon laquelle les internautes « exploitent et attribuent une confiance excessive à des conclusions issues de l’exploitation d’informations obtenues à partir d’échantillons non significatifs« . N’avons-nous jamais dit aux élèves de recouper l’info ? Le fait qu’elle soit présente partout donne-t-elle une preuve de véracité ?

7. Scientificité et médias

En science, les médias traditionnels, voire les médias scientifiques ne sont pas dépourvus de fausses informations. Une certaine presse donne une grande place aux pseudo-sciences et médecines alternatives ( ce qui peut questionner le modèle de santé également et le « pourquoi » de cet attrait). On se souviendra aussi que le premier reportage de la chaîne d’Arte en 1992 portait sur les pouvoirs surnaturels des pyramides d’Egypte, capables d’aiguiser des lames et de cuire la viande grâce à leurs ondes…

En science, les médias traditionnels, voire les médias scientifiques ne sont pas dépourvus de fausses informations. Une certaine presse donne une grande place aux pseudo-sciences et médecines alternatives ( ce qui peut questionner le modèle de santé également et le « pourquoi » de cet attrait). On se souviendra aussi que le premier reportage de la chaîne d’Arte en 1992 portait sur les pouvoirs surnaturels des pyramides d’Egypte, capables d’aiguiser des lames et de cuire la viande grâce à leurs ondes…- La temporalité des médias n’est pas forcément celle des sciences : la science est un processus lent (vérifier, accumuler des preuves, expérimenter), tandis que le modèle économique des médias actuel favorise souvent l’urgence, la vitesse, la course aux clics des internautes et la duplication (le bâtonnage est une pratique qui vise à dupliquer rapidement, sans regard critique, les dépêches AFP).

- Se méfier du terme « expert » (argument d’autorité) : certaines chaînes sont spécialistes pour inviter un chercheur controversé sans lui opposer de regard critique. D’autre part, certains habitués des plateaux gonflent un CV qui peut révéler bien des choses. On se souviendra du cas du faux expert en criminologie « depuis 40 ans », Stéphane Bourgoin.

- Vérifier le consensus scientifique sur un sujet : souvent les médias peuvent publier la dernière étude en date sur un sujet, donnant l’impression qu’il s’agit de la meilleure car la plus récente (sans attendre de voir le retour d’autres scientifiques sur le sujet).

- Se méfier de l’effet râteau (ou loi des séries) : tendance à exagérer la régularité du hasard. Exemples :

- Si plusieurs malheurs s’enchaînent d’un coup dans notre quotidien, on pense qu’on a la « poisse ». On oublie que les malheurs ne peuvent pas arriver selon des écarts constants entre eux. Le hasard peut créer des impressions de « regroupements ».

- Ce biais est souvent diffusé dans la presse (des cas « anormaux » de cancers dans une zone / un basketteur qui met plusieurs paniers et devient populaire).

- Différencier causalité et corrélation : les graphiques peuvent donner l’impression de liens de causalité entre des phénomènes. En zététique on évoque par exemple, l‘effet « cigogne ». En Alsace, les villes qui ont le plus de cigognes sur les toits ont aussi le plus de bébés. Donc les cigognes apportent les bébés. » (En fait, c’est parce que plus une ville est grosse, plus il y a de bébés. Et comme il y a plus de toits, il y a plus de cigognes »).

- Les biais statistiques : les statistiques et les chiffres sont deux des principaux soucis dans la présentation d’articles portant sur des études. Les enseignants de mathématiques ou SES auraient certainement un rôle à jouer sur ces informations chiffrées. Deux exemples :

- Le biais de proportionnalité : il s’agit d’une tendance à croire que si l’on observe l’augmentation des manifestations d’un phénomène, c’est qu’il est en hausse. Alors qu’il peut s’agir d’une amélioration des outils d’observation (exemple : on voit plus de cancers aujourd’hui. Certains y voient le lien avec un environnement qui serait moins bon. Mais cela peut être dû au fait que l’imagerie médicale actuelle peut détecter davantage de cancers et que la population vieillit.)

La négligence de la taille de l’échantillon : présent dans les théories complotistes, ce biais attribue un phénomène improbable à une cause alors qu’il est dû au hasard et à la grande taille d’un échantillon. Par exemple, certains ont vu la figure du diable (paréidolie) dans les fumées du 11 septembre 2001. Mais sur toutes les occurrences photographiques, il est facile de percevoir des formes dues au hasard.

La négligence de la taille de l’échantillon : présent dans les théories complotistes, ce biais attribue un phénomène improbable à une cause alors qu’il est dû au hasard et à la grande taille d’un échantillon. Par exemple, certains ont vu la figure du diable (paréidolie) dans les fumées du 11 septembre 2001. Mais sur toutes les occurrences photographiques, il est facile de percevoir des formes dues au hasard.

Pour D. Kahneman (Système 1 Système 2), « les statistiques produisent beaucoup d’observations qui ne demandent qu’à trouver des explications causales, mais qui ne s’y prêtent pas. Bien des faits dans le monde sont dus au hasard, y compris aux accidents d’échantillonnage. »

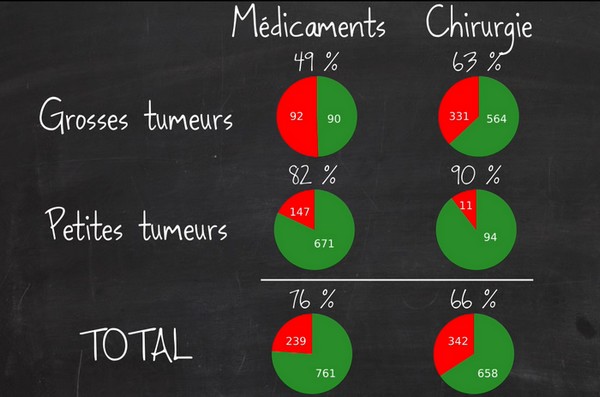

Etre vigilant face aux pourcentages, aux moyennes : certains cachent un faible nombre de sujets d’expérimentation, ce qui laisse de la place au hasard. Certaines formulations ne sont pas convaincantes (dire que le taux d’une maladie a doublé dans une région, si l’on est passé de 1/100000 à 2/100000 est peu probant). Certaines moyennes cachent l’étendue entre des données extrêmes. Il est possible de vérifier si des marges d’erreur sont indiquées dans les publications chiffrées. Enfin, certains pourcentages selon la forme qu’on leur donne, peuvent donner des résultats contradictoires comme dans le paradoxe de Simpson.

Etre vigilant face aux pourcentages, aux moyennes : certains cachent un faible nombre de sujets d’expérimentation, ce qui laisse de la place au hasard. Certaines formulations ne sont pas convaincantes (dire que le taux d’une maladie a doublé dans une région, si l’on est passé de 1/100000 à 2/100000 est peu probant). Certaines moyennes cachent l’étendue entre des données extrêmes. Il est possible de vérifier si des marges d’erreur sont indiquées dans les publications chiffrées. Enfin, certains pourcentages selon la forme qu’on leur donne, peuvent donner des résultats contradictoires comme dans le paradoxe de Simpson.

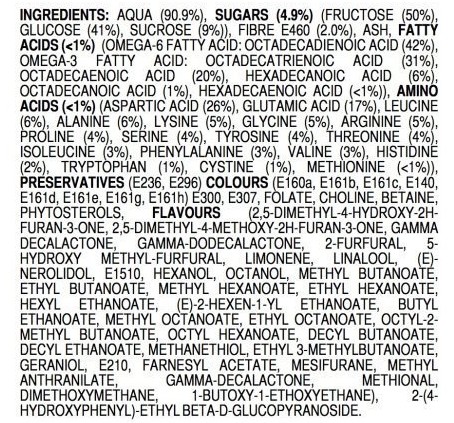

Analyser le jargon scientifique : les informations formulées dans un jargon scientifique sont souvent difficiles à appréhender. L’exemple du canular de l’eau montre comment on a pu monter des pétitions pour interdire…l’eau ! Dans le même esprit, la composition chimique de l’aliment ci-contre peut effrayer.

Analyser le jargon scientifique : les informations formulées dans un jargon scientifique sont souvent difficiles à appréhender. L’exemple du canular de l’eau montre comment on a pu monter des pétitions pour interdire…l’eau ! Dans le même esprit, la composition chimique de l’aliment ci-contre peut effrayer.

Mais il s’agit de la composition chimique…d’une fraise. On oublie souvent que tout est chimique.

8. Des réflexes pour valider l’information de manière « scientifique »

- Etre vigilant à l’égard d’une information qui conforte nos opinions

- Bien comprendre le sens des mots employés

- Observer si l’affirmation est cohérente avec les informations déjà connues sur la question (consensus scientifique)

- Cette information peut-elle faire l’objet d’une expérimentation ou bien est-ce trop extraordinaire (ce qui doit alerter) ?

- Vérifier la source des preuves apportées par l’interlocuteur

- Ne pas se laisser noyer par un argumentaire trop dense (effet Fort)

- Se demander pourquoi l’interlocuteur parle de ce dont il parle

- Suspendre son jugement si besoin, en cas de doute

- Ne pas colporter l’affirmation si elle reste douteuse

- Sur une question vitale (santé, vie sociale, etc) consulter plusieurs avis (médecins, spécialistes indépendants les uns des autres)

- Ne pas s’arrêter au titre

- Prendre la mesure des sentiments qu’éveille l’information en nous

- Lire l’article en entier avant de le partager

- Vérifier la présence d’une signature de l’article journalistique

- S’assurer de la compréhension du sens des mots

- Repérer l’usage du conditionnel

- Se demander quel est l’état du consensus scientifique sur cette question

- Se demander si l’on peut confronter cette affirmation à la réalité (par l’expérimentation)

- Observer la nature des preuves (études de cas, témoignages, expertise isolée ?)

- Dans le cas du doute : ajouter des mots clés pour vérifier l’info (canular, hoax, critique, rumeur)

- Rechercher quel média a diffusé cette information en premier, si l’article ou le reportage traite d’une actualité

- Etre très vigilant face à des pourcentages

- Vérifier l’accessibilité des données énoncées (liens)

- Se poser la question du sérieux de la revue qui publie l’étude énoncée dans l’information

- Cerner la taille du groupe étudié (est-ce extrapolé à une vaste population ?)

- Observer si la démarche des chercheurs et les méthodes sont détaillées par l’auteur

- Chercher qui a financé l’étude

____________________________________________________

Ressources pédagogiques

|

|

|

|

5 activités conçues pour de déconfinement en juin 2020.

1. Une épidémie de fausses-infos !

2. Mon cerveau me trompe-t-il face à l’info? Illusions, biais, …

3. Des faits extraordinaires ou paranormaux réclament des preuves extraordinaires.

4. Savoir déjouer les mauvais arguments dans les discussions et les sources d’infos !

5. Savoir “disséquer” une théorie du complot !

|

||

|

Ateliers clé en main : exemples « Médias et esprit critique », maths et esprit critique, Atelier Esprit critique au collège : repérer les arguments fallacieux, Parler d’énergie en cours de physique-chimie, Chimique, naturel, artificiel, synthétique : comment s’y retrouver ?, |

||

| Quelques ressources pour former nos élèves à la zététique et à l’esprit critique. PDF (cette enseignante propose une liste exhaustive des ressources sur la zététique, l’esprit critique et la démarche scientifique, parmi lesquelles le chat sceptique, la Tronche en biais, Hygiène mentale, le pharmachien, etc). | ||

Ce manuel d’Enseignement scientifique en classe de Terminale propose des éléments sur la démarche scientifique et la pensée critique. Très utile !

|

||

| La statistique expliquée à mon chat, par le créateur de la chaîne « le chat sceptique ». Des vidéos attrayantes pour comprendre les erreurs de logique dans les données chiffrées. | ||

Ressources scientifiques.

- DURAND, Thomas C. L’ironie de l’évolution. Ed. Le Seuil. 2018

- GOUTHIERE, Florian. Santé, Science. Doit-on tout gober ? Ed. Belin. 2017

- MERCIER, Hugo. SPERBER, Dan. L’énigme de la raison. Ed. Odile Jacob, 2017.

- MONVOISIN, Richard. Cours de zététique et autodéfense intellectuelle 2016-2017. Université de Grenoble.

- LOFTUS, Elisabeth. How reliable is your memory. TedGlobal, 2013.

- BAILLARGEON, Normand. Petit cours d’autodéfense intellectuelle. Lux Éditions. 2006.

- MOUKHEIBER, Albert. Votre cerveau vous joue des tours. Allary Ed., 2019.

- FEYTIT, Elisabeth. Meta de choc. chaîne de Podcast

- Ceci n’est pas un lapin. Ed. Belin. 2016

- FESTINGER, Leon. A theory of cognitive dissonance. Stanford University Press. 1957.

- HOUDE, Olivier. L’intelligence humaine n’est pas un algorithme. Ed. Odile Jacob. 2019

- ROSLING, Hans. Factfullness. Ed. Flammarion. 2019