Le numérique, l’intelligence artificielle, les algorithmes… des machines sont-elles destinées à remplacer le travail des humains? Derrière nos activités en ligne, des usagers (nous?) et des travailleurs (dans des conditions très discutables) sont pourtant nécessaires pour alimenter une économie fondée sur les données ou des contenus à mettre en avant.

Le numérique, l’intelligence artificielle, les algorithmes… des machines sont-elles destinées à remplacer le travail des humains? Derrière nos activités en ligne, des usagers (nous?) et des travailleurs (dans des conditions très discutables) sont pourtant nécessaires pour alimenter une économie fondée sur les données ou des contenus à mettre en avant.

Une éducation critique de l’information qui se veut réellement émancipatrice et citoyenne peut aider l’élève à se questionner sur ces algorithmes et leur rapport aux humains qui les épaulent. Car derrière les écrans, certaines tâches humaines et nombre de nos activités peuvent être digérées sous différentes formes : ceci afin de créer de la valeur marchande, même au travers d’activités de plaisir (Antonio A. Casilli parle de playbor, contraction des notions de travail et de plaisir), et optimiser des plateformes, avec leurs algorithmes et leurs services. Il s’agira alors, avec l’élève, de comprendre l’utilisation des données (et des nôtres) et les conditions de travail de certains acteurs (et de nous-mêmes) peu visibles derrière nos pratiques en ligne. Car il est important, parfois, de « se mettre en en mode manuel” (pour reprendre les mots de Dominique Cardon) quand nous sommes connectés.

- Nom du professeur documentaliste : Raphaël Heredia

- E-mail : rheredia[arobase]ac-besancon.fr

- Nom de l’établissement : collège Victor Schoelcher

- Niveau : Troisième

- Cadre : EMI / EMC

- Déroulé : 2h

- Matériel : tablettes ou postes informatiques

- Outils numériques : Genially / LaDigitale-Digiscreen

Compétences EMI / numériques :

- Se questionner sur les enjeux démocratiques liés à la production d’information en ligne

- Adopter un regard critique sur les enjeux de l’information en ligne

- Comprendre les traitements de l’information numérique

- Maîtriser ses traces et gérer les données personnelles pour protéger sa vie privée et celle des autres, et adopter une pratique éclairée

Compétences EMC

- Construire une culture civique dans un monde numérique : débat démocratique, engagement

Contexte

Objectif: Cette séquence est conçue pour avoir une vue d’ensemble du rapport des algorithmes aux tâches humaines qui les sous-tendent (qu’elles soient les nôtres, ou celles de travailleurs du web). Elle permet d’amorcer un travail qui peut être plus conséquent en lycée (en SNT ou en SES par exemple).

Le but est aussi de nourrir une réflexion sur les dessous des algorithmes afin d’avoir une attitude réflexive, critique sur ses usages en ligne. Ce qui peut déboucher sur des pratiques citoyennes liées au débat, la controverse et l’émergence de solutions.

Il ne s’agit pas non plus de tomber dans des paniques morales sur les écrans ou des plateformes qui ne seraient que négatives ou malveillantes. Il s’agit juste d’apporter de la nuance et d’user d’esprit critique sur un modèle économique que les Gafam, ou d’autres plate-formes de service déploient. Les algorithmes sont parfois le reflet des données qu’ils ont à traiter et des représentations humaines de ceux et celles qui les conçoivent.

- Pré-requis : notion d’algorithme [l’objectif n’est pas de comprendre le fonctionnement d’un algorithme – mais de comprendre sa relation à nous : comment on l’alimente, comment on l’améliore, qui a œuvré derrière l’algorithme pour que je reçoive une information].

Pour un pré-travail sur le fonctionnement des algorithmes , on pourra s’appuyer sur les ressources suivantes

Pour une vue d’ensemble sur les métiers du web incluant les travailleurs invisibles du Web

Déroulement

Objectif 5 min

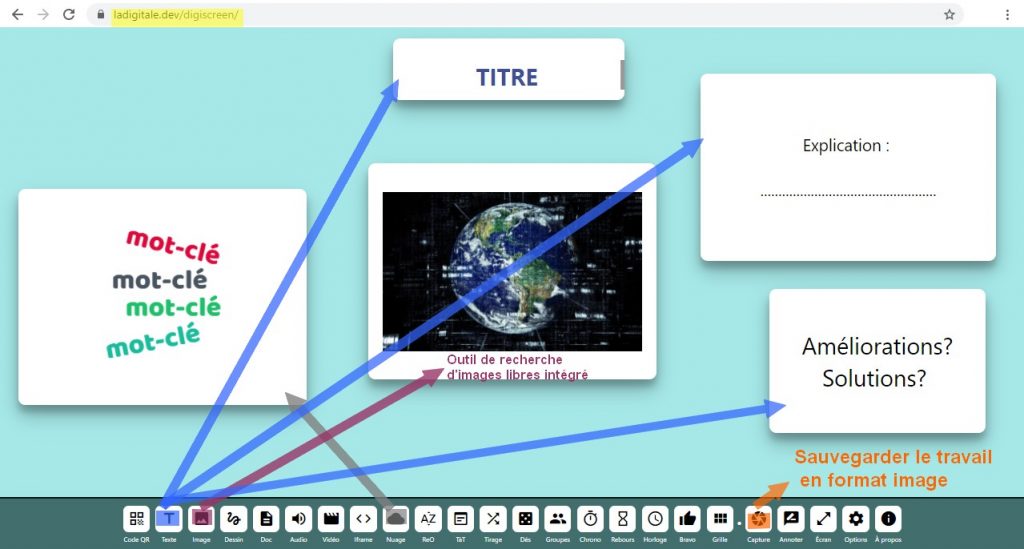

- Présentation de l’objectif : Créer une image-affiche pour sensibiliser ses camarades sur un sujet lié à l’intervention humaine derrière les algorithmes et l’information qui nous arrive.

-> avec l’outil la digitale/Digiscreen où apparaitront : le titre, des mots clés en nuage, un texte explicatif , les solutions qu’on entrevoit face au problème, image(s) illustratrice(s)

(On peut démarrer la séance avec un questionnement sur une image)

[Source image : Il nous a été difficile de retrouver la source originelle. Cette image était très relayée.]

Répartition par 2 5 min

En sélectionnant un personnage sur le support Genially, on accède à des informations et une ressource vidéo afin de construire son affiche.

Mise en activité 45 min

-> Les images-affiches créées sont enregistrées dans un dossier commun pour être affichées en heure 2.

Mise en commun 45 min Chaque groupe présente son image créée. Ce qui amène des échanges.

Conclusion 10 min Bilan – Pour aller plus loin (selon le temps), on peut visionner cette vidéo de la série Invisibles avec le sociologue Antonio Casilli.

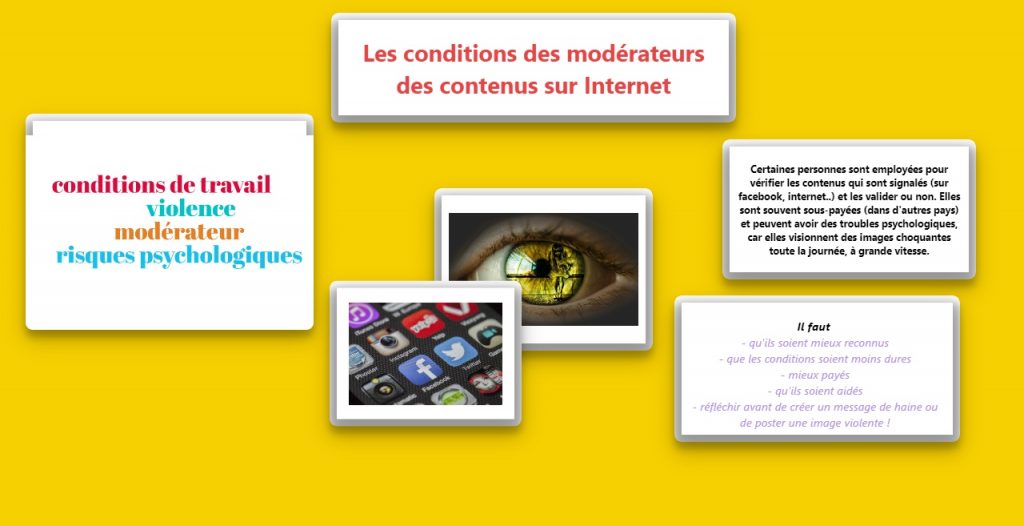

Exemple de travail réalisé:

Explications supplémentaires :

Dans ces 11 points soulevés, l’algorithme nécessite des données humaines ou un travail humain pour apprendre et s’améliorer. Certain points reprennent les trois types de digital labor, tels qu’énoncés par le chercheur Antonio T. Casilli (plateformes de services à la demande, plateformes de microtravail, plateformes sociales qui capitalisent sur les données générées bénévolement par les usagers). C’est l’intervention humaine qui, au final, rendrait l’IA plus efficace.

Plateformes de microtravail : dans la lignée d’ Amazon Mecanical Turk, ces plateformes proposent d’effectuer des microtâches rapides à des humains (payés à la tâche, ce qui reviendrait à 1 ou 2 € l’heure) pour améliorer les algorithmes. Consulter : Série Invisibles : Derrière les algorithmes – FranceTV-Slash / Le livre d’Antonio A. Casilli, En attendant les robots

Plateformes de microtravail : dans la lignée d’ Amazon Mecanical Turk, ces plateformes proposent d’effectuer des microtâches rapides à des humains (payés à la tâche, ce qui reviendrait à 1 ou 2 € l’heure) pour améliorer les algorithmes. Consulter : Série Invisibles : Derrière les algorithmes – FranceTV-Slash / Le livre d’Antonio A. Casilli, En attendant les robots

Modérateur de contenu : souvent invisibilisés, des employés sont chargés de modérer les pires contenus du web dans des conditions psychologiques parfois insoutenables (souvent employés dans des pays en voie de développement et dans des conditions indécentes). Le fait d’être exposé en permanence à des images de violence à un impact traumatique sur nombre d’entre eux. A cela s’ajoutent les représentations culturelles, souvent différentes entre le modérateur et l’usager, qui seront issus de deux endroits différents. Consulter : Série Invisibles : Dans l’enfer des modérateurs – FranceTV-Slash / Le livre de Sarah T. Roberts, Derrière les écrans / Le livre de Romain Badouard, Les nouvelles lois du web (chapitre sur la modération) / Le. Documentaire : The Cleaners.

Modérateur de contenu : souvent invisibilisés, des employés sont chargés de modérer les pires contenus du web dans des conditions psychologiques parfois insoutenables (souvent employés dans des pays en voie de développement et dans des conditions indécentes). Le fait d’être exposé en permanence à des images de violence à un impact traumatique sur nombre d’entre eux. A cela s’ajoutent les représentations culturelles, souvent différentes entre le modérateur et l’usager, qui seront issus de deux endroits différents. Consulter : Série Invisibles : Dans l’enfer des modérateurs – FranceTV-Slash / Le livre de Sarah T. Roberts, Derrière les écrans / Le livre de Romain Badouard, Les nouvelles lois du web (chapitre sur la modération) / Le. Documentaire : The Cleaners.

Bulles de filtre et chambres d’écho : on parle de bulle de filtre à propos du filtrage généré par les algorithmes et qui aurait tendance à nous enfermer dans un tri personnalisé de l’information. De nombreux chercheurs pointent la faiblesse de ce concept car il surestimerait l’influence de l’algorithme sur nos choix. Il vaudrait mieux parler de chambres d’écho : une situation où c’est plutôt l’usager qui peut s’enfermer de lui même dans une bulle et un biais de confirmation, en sélectionnant des contenus ou des opinions qui sont amplifiés sur le web ou en suivant ses pairs. Pour certains, Internet permettrait d’être plus facilement au contact de sources contradictoires que dans une vie « débranchée ». Consulter : DEFAKATOR. Vite fait, Rester trop dans sa bulle.

Bulles de filtre et chambres d’écho : on parle de bulle de filtre à propos du filtrage généré par les algorithmes et qui aurait tendance à nous enfermer dans un tri personnalisé de l’information. De nombreux chercheurs pointent la faiblesse de ce concept car il surestimerait l’influence de l’algorithme sur nos choix. Il vaudrait mieux parler de chambres d’écho : une situation où c’est plutôt l’usager qui peut s’enfermer de lui même dans une bulle et un biais de confirmation, en sélectionnant des contenus ou des opinions qui sont amplifiés sur le web ou en suivant ses pairs. Pour certains, Internet permettrait d’être plus facilement au contact de sources contradictoires que dans une vie « débranchée ». Consulter : DEFAKATOR. Vite fait, Rester trop dans sa bulle.

Plateformes de service à la demande : ces plateformes telles Uber Eats, en mettant en relation un demandeur et fournisseur potentiel de service (livreur, chauffeur..) dont l’emploi reste précaire, leur font générer de la donnée qui améliore l’algorithme (amélioration de géolocalisation, notation et réputation…). Consulter : Série Invisibles : Ce qu’implique une commande UBER EATS – FranceTV-Slash / Le livre d’Antonio A. Casilli, En attendant les robots

Plateformes de service à la demande : ces plateformes telles Uber Eats, en mettant en relation un demandeur et fournisseur potentiel de service (livreur, chauffeur..) dont l’emploi reste précaire, leur font générer de la donnée qui améliore l’algorithme (amélioration de géolocalisation, notation et réputation…). Consulter : Série Invisibles : Ce qu’implique une commande UBER EATS – FranceTV-Slash / Le livre d’Antonio A. Casilli, En attendant les robots

Fermes à clic et ferme à lien : Des groupes de personnes employées par une entreprise fraudeuse pour générer des « like », des clics publicitaires, ou des liens sur des faux-sites, pour rendre populaire un contenu, une information, un produit, une personnalité. Consulter : FRANCE 2, le business des fermes à clic

Fermes à clic et ferme à lien : Des groupes de personnes employées par une entreprise fraudeuse pour générer des « like », des clics publicitaires, ou des liens sur des faux-sites, pour rendre populaire un contenu, une information, un produit, une personnalité. Consulter : FRANCE 2, le business des fermes à clic

Algorithmes de personnalisation/suggestion : le croisement des données fournies par les utilisateurs permet à l’IA de générer des profils-type et d’être prédictive, afin d’affiner la suggestion de contenus personnalisés (Deezer, Amazon, publicités Google, par ex.). Ce phénomène peut dépasser l’usage du web (il peut concerner les achats dans une enseigne à l’aide d’une carte fidélité). Consulter : MIKADOC. Que sait Google de nous? / Le livre de D. Cardon, A quoi rêvent les algorithmes.

Algorithmes de personnalisation/suggestion : le croisement des données fournies par les utilisateurs permet à l’IA de générer des profils-type et d’être prédictive, afin d’affiner la suggestion de contenus personnalisés (Deezer, Amazon, publicités Google, par ex.). Ce phénomène peut dépasser l’usage du web (il peut concerner les achats dans une enseigne à l’aide d’une carte fidélité). Consulter : MIKADOC. Que sait Google de nous? / Le livre de D. Cardon, A quoi rêvent les algorithmes.

Astroturfing : Il s’agit d’une désinformation populaire planifiée. Des internautes planifient la publication ou le partage d’un contenu pour faire croire à une impression de grande popularité et de succès « naturel « de ce contenu (très présent dans les débats politiques, sociaux et le marketing viral). Le but est parfois de créer une panique morale autour d’une polémique. Une analyse de la viralité des partages peut faire apparaître que certains comptes bien spécifiques sont derrière la popularité apparente. Consulter : FRANCEINFO. la fausse-polémique de l’Eviangate. / DEFAKATOR. Vite fait, L’astroturfing.

Astroturfing : Il s’agit d’une désinformation populaire planifiée. Des internautes planifient la publication ou le partage d’un contenu pour faire croire à une impression de grande popularité et de succès « naturel « de ce contenu (très présent dans les débats politiques, sociaux et le marketing viral). Le but est parfois de créer une panique morale autour d’une polémique. Une analyse de la viralité des partages peut faire apparaître que certains comptes bien spécifiques sont derrière la popularité apparente. Consulter : FRANCEINFO. la fausse-polémique de l’Eviangate. / DEFAKATOR. Vite fait, L’astroturfing.

Playbor et travail « gratuit » des utilisateurs de plateformes sociales : placer des tags sur une photo Instagram, décrire un contenu. L’Intelligence artificielle peut apprendre grâce aux données que nous lui fournissons gratuitement ! L’IA n’étant pas toujours fiable et dépendant en partie, du travail humain et des représentations issues de nos données, comme en témoigne l’article suivant. Consulter : AFFORDANCE.INFO. Les perroquets stochastiques et l’attaque de la typographie géante.

Playbor et travail « gratuit » des utilisateurs de plateformes sociales : placer des tags sur une photo Instagram, décrire un contenu. L’Intelligence artificielle peut apprendre grâce aux données que nous lui fournissons gratuitement ! L’IA n’étant pas toujours fiable et dépendant en partie, du travail humain et des représentations issues de nos données, comme en témoigne l’article suivant. Consulter : AFFORDANCE.INFO. Les perroquets stochastiques et l’attaque de la typographie géante.

Connexion et micro-tâches (exemple du ReCaptcha) : la sécurisation des identifications a permis de générer des micro-tâches lors des connexions. Ainsi le ReCaptcha, qui nous demande d’identifier des formes ou des lettres (pour « prouver que vous n’êtes pas un robot ») a pu permettre de numériser collectivement des bouts de livres papier. L’internaute aide alors l’IA à numériser et mieux identifier des formes. Consulter : SHUBHAM SHARMA. Qu’est-ce qu’un CAPTCHA ? Google nous fait travailler gratuitement.

Connexion et micro-tâches (exemple du ReCaptcha) : la sécurisation des identifications a permis de générer des micro-tâches lors des connexions. Ainsi le ReCaptcha, qui nous demande d’identifier des formes ou des lettres (pour « prouver que vous n’êtes pas un robot ») a pu permettre de numériser collectivement des bouts de livres papier. L’internaute aide alors l’IA à numériser et mieux identifier des formes. Consulter : SHUBHAM SHARMA. Qu’est-ce qu’un CAPTCHA ? Google nous fait travailler gratuitement.

Assistants vocaux et données : Certains lanceurs d’alerte ont témoigné du fait que de nombreux employés « épaulent » certains assistants vocaux type SIRI, pour améliorer l’IA d’après des bouts de discussions enregistrées. Consulter : Série Invisibles. Les micros des appareils Apple sont ouverts en permanence – FranceTV-Slash

Assistants vocaux et données : Certains lanceurs d’alerte ont témoigné du fait que de nombreux employés « épaulent » certains assistants vocaux type SIRI, pour améliorer l’IA d’après des bouts de discussions enregistrées. Consulter : Série Invisibles. Les micros des appareils Apple sont ouverts en permanence – FranceTV-Slash

Algorithmes et discriminations : La chercheuse Timnit Gebru a été licenciée il y a quelques mois par la firme Google. Elle pointait sur des « discriminations » de la part des algorithmes liées à la reconnaissance des personnes noires et des femmes. L’une des pistes serait les représentations des concepteurs des IA où dominent certains traits culturels et sociaux. En 2015, Google s’était excusée pour avoir identifié un couple d’afro-américains comme « gorilles« . Consulter : CRAFT. Les intelligences artificielles sont racistes, sexistes… et c’est de notre faute / AFFORDANCE.INFO. Les perroquets stochastiques et l’attaque de la typographie géante / Plus technique : SCIENCE4ALL. L’IA est raciste (mais vous aussi!).

Algorithmes et discriminations : La chercheuse Timnit Gebru a été licenciée il y a quelques mois par la firme Google. Elle pointait sur des « discriminations » de la part des algorithmes liées à la reconnaissance des personnes noires et des femmes. L’une des pistes serait les représentations des concepteurs des IA où dominent certains traits culturels et sociaux. En 2015, Google s’était excusée pour avoir identifié un couple d’afro-américains comme « gorilles« . Consulter : CRAFT. Les intelligences artificielles sont racistes, sexistes… et c’est de notre faute / AFFORDANCE.INFO. Les perroquets stochastiques et l’attaque de la typographie géante / Plus technique : SCIENCE4ALL. L’IA est raciste (mais vous aussi!).

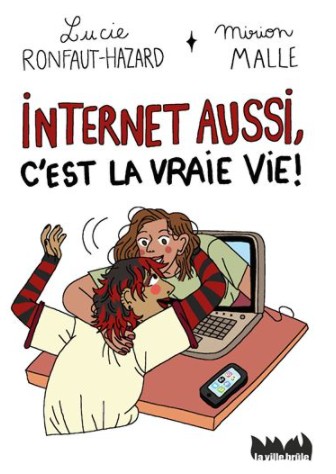

Pour le CDI: ce livre (à gauche) adapté aux adolescents évoque tous ces sujets.

Pour le CDI: ce livre (à gauche) adapté aux adolescents évoque tous ces sujets.

Sources scientifiques

- CARDON, Dominique. A quoi rêvent les algorithmes. Seuil. 2015

- CASILLI, Antonio A. En attendant les robots. Seuil. 2019

- ROBERTS, Sarah T. Derrière les écrans. La découverte. 2020

- BADOUARD, Romain. Les nouvelles lois du web. Seuil. 2020

- ERTZSCHEID, Olivier. Les perroquets stochastiques et l’attaque de la typographie géante. En ligne : Affordance.info. 2021

- ERTZSCHEID, Olivier. L’appétit des géants : Pouvoir des algorithmes, ambitions des plateformes. C&F Editions, 2017

- SCIENCE4ALL. L’IA est raciste (mais vous aussi!). En ligne. 2018

- FLETCHER, Richard. La vérité sur les bulles de filtre, déconstruire certains mythes (en anglais). En ligne. Oxford University / Reutersinstitute.politics.ox.ac.uk . 2020 [D’après une publication Twitter de la chercheuse en Sciences de l’éducation Charlotte Barbier.]